Samedi 22 septembre, j’avais la chance de faire partie de la centaine de joyeux drilles assistant aux conférences du SDDAY 2018 organisé par Sandrine Bertrand et David Depierris que je félicite à nouveau, comme j’ai pu le faire dans mon compte rendu publié sur le blog de Korleon’Biz ici.

C’est juste une petite question SEO

Un oiseau rare du SEO

Jérôme Rossignol déroulait une conférence sur la fonctionnement et l’usage des crawlers, un brin technique il faut l’avouer. Mais comme j’aime être bercé par une voix chantante à l’accent du sud, j’étais parfaitement attentif malgré tout. Au cours de cette conférence, Jérôme à donné son point de vue sur un aspect SEO lié au crawl du googlebot, sur lequel j’avais une vision différente.

Le point de vue de Jérôme

Admettons que sur une page X, j’ai 10 liens internes sortants. 5 liens vers une page A, B, C , D, E (donc un lien pour chacune). Mais aussi 5 autres liens pointant tous vers une page A. Alors, le jus transmis à la page A est 10% ou est 50% ?

Jérôme nous explique que Google ne va prendre en compte que le premier lien vers la page A. Ainsi, le jus distribué à la page A n’est pas 5/10e, ni même 1/6e, mais bien 1/10e . Cet état de fait aboutit donc à une perte de PageRank puisque 4/10e ne sont pas redistribués.

Il apporte une précision, qui n’est pas discutée ici. C’est qu’il est possible de faire des liens différents vers la page A, en les ancrant par un dièse à la fin ndd.fr/mapageA#zoneprecise1 . Ainsi chaque lien pointe vers une zone précise de la page A, et le jus est bien transmis.

Mon modeste point de vue

Alexandre et Christelle, la crème de la crème.

Avec toute l’impertinence que m’attribue Christelle Milan, je me suis permis de poser une question, car j’ai toujours vu les choses autrement.

Selon moi, la page A reçoit bien 5/10e du jus, mais en revanche, seule l’ancre du premier lien est prise en compte par Google pour tout ce qui concerne la puissance de l’ancre et les aspects sémantiques (ancre mais aussi textes qui entourent le lien).

Je n’étais pas d’accord avec mon illustre ainé, car ce constat signifierait qu’ajouter un lien vers une page disposant déjà d’un lien via le menu, via un footer ou via le fil d’Ariane, aboutirait ainsi à une fuite de PageRank, et donc à un résultat contre-productif. Constat qui m’interpelle.

Appel(s) à un ami SEO

Jérôme n’est pas le premier venu en SEO, il est le papa du logiciel respecté Visiblis, et bien évidemment je respecte tout cela, et je le remercie encore pour nos longs échanges lors du repas sur le sujet. Mais j’aime bien comprendre les choses, alors j’ai embêté quelques autres collègues.

Je me suis dit, je vais contacter l’ami Sylvain Peyronnet qui va me dire, c’est toi le meilleur Régis, tu as toujours tout compris mieux que les autres, tu as raison. Baaaaaah, en fait non, il m’a expliqué tout en nuance que cela était compliqué mais qu’il ne pouvait pas aller réellement dans mon sens.

Voulant mieux comprendre, je me suis adressé aussi à Sylvain Deauré, papa de cocon.se que je fais tourner toutes les semaines et que j’affectionne particulièrement pour sa simplicité d’utilisation. La question est de savoir comment Cocon.SE calcule la distribution du PRI alors.

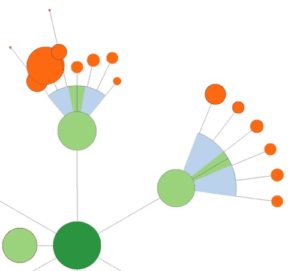

Un petit bout de cocon.se

Ces différents échanges m’ont permis de comprendre qu’il y a en fait deux sujets en un.

Allons plus loin : PageRank brut et Pagerank Thématique

Pagerank brut

Le pagerank brut est la base dans les critères de classement de notre cher Google. Il permet de prioriser la crawl d’une page par rapport à une autre, et joue encore sur le classement dans les résultats.

Ce jus brut fonctionnerait comme le veut mon interprétation des choses. C’est-à-dire que dans mon exemple, la page A reçoit bien 5/10e du jus brut redistribué par la page X.

C’est ainsi que le calcule également cocon.se

Pagerank thématique

Le pagerank thématique s’attache à donner du sens aux liens. Ainsi, dans notre exemple, seul le premier lien fait sens, et donc la page A ne recevra qu’uniquement 1/10e de ce jus thématique en provenance de la page X.

C’est contradictoire ce que tu nous racontes ?

Oui et non. En premier lieu, le pagerank brut est à prendre en considération car il influence le crawl des robots mais les liens peuvent ensuite ne plus avoir la même valeur lorsque le pagerank thématique est pris en compte. Et dans ce cas il est possible d’arriver à la situation extrême où seul le premier lien est pris en compte.

Finalement, cela dépend des requêtes. Ce qui explique pourquoi, la même action de maillage, sur des sites techniquement identiques, mais aux sujets différents, peut aboutir à des conséquences différentes d’un point de vue SEO.

Parfois une page profitera de ces multiples liens évoqués dans l’exemple, son PR brut grossira et elle grimpera dans les résultats de Google. Parfois c’est en enlevant des liens (tels que ceux du menu), qui permettra de faire plus de sens aux liens intext, qui fera que la même page grimpera dans les résultats de Google, mais cette fois grâce à l’amélioration de son PR Thématique.

Ceteris paribus.

Mais alors, comment sait-on ce qu’on doit faire chef ?

Alors… je ne sais pas.

Je remercie Jérôme, Sylvain et surtout Sylvain (je ne donne pas les noms pour qu’ils pensent tous les deux être mon préféré), vous m’avez fait réfléchir. Et certains diront qu’il est préférable de me faire réfléchir que de me faire chanter.

A quand une table ronde sur le sujet entre ces immenses spécialistes ?

Je serai assis au premier rang et j’aurai le secret espoir de comprendre. Et vous, vous en pensez quoi de tout cela ?

Commentaires bienvenus, et si c’est pas juste un spamco je garde le le lien dofollow bien entendu.

Merci pour ton article , et surtout pour cette réflexion.

J’étais toujours parti sur le principe de base qu’un seul lien vers la page A compté, mais a priori la notion de pagerank brut me semble aussi logique pour le crawl…

Mais alors comment et quand est fait la distinction du pagerank thématique VS pagerank brut dans l’aglo?

Après coup? MAJ ou filtres spécifiques?

Si j’ai bien compris ton explication, chacun a sa propre interprétation du PRI et personne n’en sais vraiment comment cela se passe réellement ??

Quand tu dis finalement cela dépends des requêtes, tu parles du calcul du pagerank ?

@adrien Je n’ai pas dit cela. Je dis que c’est bien plus compliqué que cela, qu’il y a une zone grise, mais je ne dis pas que nos amis spécialistes ne la comprennent pas.

Je dis ça dépend, pour dire que parfois le positionnement est plus influencé par l’un que par l’autre.

En revanche, si tu as une question bienveillante, je pense que des précisons peuvent arriver en commentaire. Un certain Sylvain D. est chaud ^^

Hello Régis.

Une question bien intéressante :-)

Parmi les critères qui “divisent” il y a la notion du nombre de liens d’une page A vers une page B, de la prise en compte ou non du nofollow, des ancres, etc. Il faut être honnête : personne n’a de réponse précise sur la manière de procéder chez Google.

Pour ma part, je rajouterais un élément qui n’est pas apparu dans ton article : l’emplacement du lien dans la page. On peut tout à fait attribuer un poids aux liens en fonction de ces différents critères, pour aboutir à un calcul pondéré, et avoir encore une autre vision. Cela permet très concrètement de minimiser l’impact d’un menu ou d’un footer, et ça fait partie des choses que l’on expérimente sur https://www.crowl.tech/ (oui c’est de la pub, mais c’est opensource et gratuit :-) ).

Mon point de vue c’est qu’il y a très probablement plusieurs “PageRanks” en parallèle, et qu’il serait bien réducteur de n’en considérer qu’un seul.

Est-ce qu’on a des cas concret permettant de valider ou d’invalider ces théories ?

Et comment savoir si les modifications de position sont liées à la l’optimisation onsite ou si c’est olié à d’autres critères (portefeuille de liens, webperf, météo ? )

@aurelien Pour ce qui est des autres critères, ils sont ignorés volontairement. D’où le ceteris paribus ;-)

Retour très intéressant sur une question ouverte sans certitude ici.

J’aurais tendance à privilégier un seul lien vers la page dans le contenu d’une page sans réfléchir aux liens du header / footer.

Cette notion de page rank thématique est très intéressante, mais très difficile à estimer non?

Dans tous les cas je pense que répéter un lien s’il a du sens pour l’utilisateur n’est pas une mauvaise chose (menu, fil d’ariane, contenu de la page si pertinent…) pour aider plus la personne plutôt que les robots ?

Hello,

Merci pour cet article, qui a le mérite de faire se poser des questions !

La confrontation des points de vues, surtout avec de tels profils, est toujours enrichissante.

En tout cas, la conclusion que j’en fais perso, c’est que d’une manière général, PR brut ou filtres supplémentaires ou pas, la “tendance” est à la minimisation du nombre de liens. Réduire les liens menus et footer, éviter les doublons de liens dans la page… Varier les ancres, y compris en maillage interne… Etc.

Après, pour ce qui est du calcul scientifique, j’ai envie de dire qu’on peut avancer sans en être sur.

Salut,

La question de fond c’est pour moi : “peut on tester et valider les différentes hypothèses ?” et malheureusement la réponse est non.

Après tout Google peut bien utiliser 5 versions du Page Rank et Qwant 27 (car on parle de SEO de manière générale), et l’un comme l’autre peuvent bien ajuster les variables aussi souvent qu’ils l’ont envie… En fonction des typologies de sites.

Sur le PR théma et le surfeur raisonnable… Le bot va suivre le lien le plus… raisonnable, et ce n’est pas obligatoirement le 1er ;)

Bref tout ce que je sais c’est que je ne sais rien quoi ^^

Merci pour cet article. Effectivement je me dis de plus en plus qu’il faut voir ce que font les concurrents sur la SERP (si du SEO est appliqué) afin de mieux comprendre quels sont les critères valorisés par Google sur les requêtes cibles et reproduire une stratégie similaire ce qui n’est pas forcément très simple à faire…

Comme d’habitude on restera donc sur la fameuse réponse “ça dépend de la requête”

merci pour cet article très intéressant. Perso je me dis que ce qui est utile pour l’utilisateur dans sa compréhension du contenu et dans ses interactions sur les pages (ux writing) ne peut qu’être positif, tant qu’on reste dans un univers sémantique cohérent et logique pour l’utilisateur.

Vue que Google ne nous dit jamais rien de vraiment concret …

J’adore ton approche, merci de nous avoir partagé tes certitudes, tes doutes et les infos que tu as pu glaner. C’est l’essence même du SEO ce genre de démarche.

Prenez environ 1000 sites, faites l’expérience suivante :

Sur chaque site, sur une ou plusieurs pages, placez 10 liens vers des pages profondes identiques, mais avec des environnements de liens TRÈS différents. Sur les pages cibles, essayez de faire que la page puisse répondre à chacun des environnements pour que les prédictions de GG sur chacun des liens puissent être satisfaites (un peu de boulot je le reconnais).

Laissez mariner.

Allez sur GG puis regardez quels sont les liens qui marchent le mieux en vous servant des termes utilisés dans l’environnement de chaque lien. Le premier lien à chaque fois ? Ou un autre ?

Il y a quelques années, j’avais aussi mené un test pour savoir si les liens via ancres nommées apportaient du “PR Interne” aux pages, et ça marchait. Du coup, on faisait plusieurs liens : le premier, vers l’URL “normale” de la page, et le(s) suivant(s) vers une ancre située à l’intérieur du contenu. Ça marchait assez bien pour avoir des mini-snippets, d’ailleurs, donc ça devait bien être pris en compte quelque part.

Daniel Roch, de Seomix, semble partager mon avis Liens et transfert de pagerank et de popularité, mais le débat reste ouvert …

et ben, je ne ne pensais pas que mon tout modeste article dominical aurait autant de commentaires, sincèrement. Merci à tous pour votre retour.

@Jérome … tu as raison, mais j’aime bien ne pas avoir totalement tort, alors je creuse, je creuse

@didier : Oui, c’est d’ailleurs ce qu’expliquait brillamment Jérome, et je le rejoignais là dessus. Si les liens internes sont affublés d’un dièse malin, cela transmets la totalité du jus (transmettrait en tout cas).

@christian : Sympa ton idée, je vais commencer par laisser mariner déjà pour voir ^^

@nicolas : Oui, il y a ensuite une pondération qui est effectué entre la position du lien (menu, footer, fil d’ariane, intext), cela semble être bien le cas. Mais pour le coup, je m’interrogeais en ôtant cet aspect pondération, histoire de me dire… “Mais alors, c’est positif ou c’est négatif si j’ajoute un lien interne vers cette page?”. Voilà tout.

@Guillaume : pas con !

@sylvainv : je n’ai pas parlé de surfeur raisonnable, justement pour garder un sens raisonnable à tout ça. L’idée était surtout de donner une direction à ce vecteur de croissance SEO, dont on a tous bien compris le sens en revanche.

@remi : oui pour les tendances. J’aime bien avoir des convictions pour avancer néanmoins, même si ça n’empêche pas de tester à côté pour se faire. Après, ça reste des convictions, pas la vérité.

@Quentin : et répéter un lien plusieurs fois dans un long texte, oublions le fil d’Ariane et le reste que google doit surement pondérer de manière “raisonnable”. Dans ce cas, bon ou mauvais d’avoir deux liens intext même si ça fait sens pour l’utilisateur. THAT IS ZE QUESTION !

@Aurélien : évidemment qu’il y a d’autres critères, mais si on les active tous dans le même sens c’est mieux. Parfois, on peut faire 10 actions, une négative, mais les résultats sont positifs, et si on se tient à ça on reproduira l’erreur à chaque fois, alors qu’on pourrait avoir tout bon en fait non ?

@adrien : quand je dis ça dépend de la requête, je veux dire que, si on oppose PR brut et PR thématique, alors dans certains cas, certaines requêtes, il vaut mieux viser l’un que l’autre. Et dans d’autres cas, ce serait le contraire. Comme disait Woody Allen, l’homme exploite l’homme, et parfois, c’est le contraire !

@Xavier : pour répondre à tes questions, je dirais qu’on n’en sait rien, en tout cas à mon modeste niveau. Et cela est surement encore plus flou, lorsque on ajoute la notion du surfeur raisonnable.

Dommage que les journées sont si courtes, et la pile de travaux perso en retard bien trop grande, car ça m’a bien motivé de vous lire en fait. Je verrai avec mes supers collègues de chez KB si on peut mettre un test en place, après avoir creusé plus en profondeur la question tout de même.

Très bon article dont le sujet revient souvent dans les questions. Et pour lequel aucune réponse n’est faite avec certitude. Face à la relative complexité du calcul, des avis divergents quant aux réponses, ma question est de savoir si le temps passé à réfléchir sur quels(s) lien(s) mettre en place pour mon maillage interne a un retour potentiel sur investissement ?

Mais d’un point de vue intellectuel, le sujet est très intéressant.

Bonsoir Régis,

Ce qu’il ressort des reflexions entre spécialistes mais aussi des commentaires, c’est qu’il n’y a pas de réponse précise quand on évoque la question de la distribution du PageRank. Selon moi il y a une conséquence directe de la typologie de site avec tout ce qui est dit ici. Par exemple : un site dont la théma est “médicale, pharmaceutique” n’aura pas la même prise en compte qu’un site sur l’aide à domicile. Il y a forcément une vision globale des moteurs de recherche sur les différents sujets.

Ainsi, le niveau de lecture de site typé “sciences” sera plus élevé, avec moins de tolérances aux fautes, des emplacements de liens “généralement constaté” bien différents des autres typologies, et probablement un ratio texte/page très élevé.

Sur les thématiques moins évidentes à cerner pour les moteurs, ils appliquent un traitement plus permissif puisqu’il n’y a pas de norme. C’est dans ce cadre que la distribution du PR pourrait parfois se faire à l’unité “physique” (répartition de tous le jus), parfois à l’unité logique (une partie du linkjuice n’est pas transmis).

Enfin, je suis preneur de la table ronde ! et des résultats de la suggestion de test de Christian M – car je n’ai pas 1K sites sous la main)

Question très ardue en effet. Je me souviens avoir lancé le débat sur Twitter il y a 2 ans environ – mais comme sur ton billet, personne ne semblait véritablement tomber d’accord :)

J’aurais tendance à penser, que logiquement, la totalité du PR doit être redistribué et qu’une « déperdition » n’est pas possible/logique (avec petite prime à l’ancrage sur 1er lien). Donc d’être d’accord avec toi.

Je vais tester l’idée de Christian (merci Christian ! :)) et reviens pour vous donnez les résultats de ma petite enquête… le temps de laisser mijoter ! ;)

Merci en tout cas pour ce petit billet très plaisant et qui a le mérite de soulever une vraie question.

@Pierre merci !

Perso, j’ai fait le test et je connais la réponse ;-)

Mais comme pour beaucoup de choses en SEO :

“Ne pas toujours tout croire, mais faire soi-même les tests sur une grande quantité de sites (1000 est souvent pas mal)”

Analyse intéressante, un point de vue que je partage, merci pour l’article !